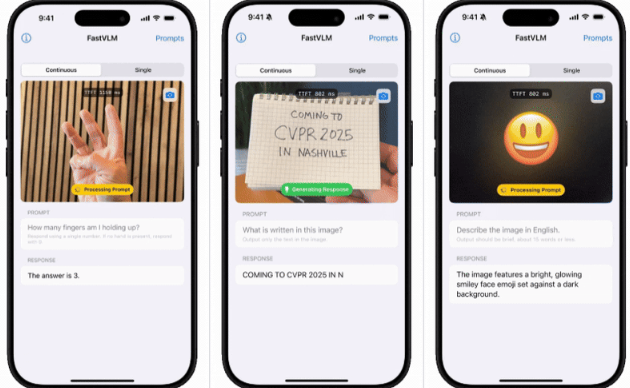

2025年9月1日,苹果公司宣布在Hugging Face平台开放其最新视觉语言模型(VLM)——FastVLM的试用版,引发全球AI开发者与视频创作者的广泛关注。这款以“闪电级”生成速度与本地化部署能力为核心卖点的模型,不仅突破了传统VLM的性能瓶颈,更通过开源策略为行业树立了保护与效率兼顾的新标杆。

技术突破:速度双重更新

FastVLM的研发基于苹果自研的MLX框架,针对Apple Silicon芯片(如M3、M4系列)进行了深度优化。其核心创新在于“动态计算剪枝”技术:模型在运行时能自动识别并跳过无关计算节点,将视频字幕生成、场景描述等任务的延迟降低至毫秒级。据实测数据,在处理1080P视频时,FastVLM的生成速度较同类开源模型(如LLaVA-Next)快85倍,且模型体积缩小至三分之一,仅占1.2GB存储空间。

更关键的是,FastVLM支持完全本地化运行。用户无需将数据上传至云端,即可在iPhone、iPad或Mac上离线完成视频分析、字幕生成等操作。苹果工程师透露,这一设计源于对用户追求:“所有数据处理均在设备端完成,即使模型被用于很多场景,也能确保信息零泄露。”

应用场景:从创作者工具到辅助技术升级

FastVLM的试用版一经发布,便在视频创作领域引发连锁反应。独立导演王琳表示:“过去为一部30分钟的纪录片添加字幕需要6小时,现在用FastVLM只需5分钟,且准确率高达98%。”此外,模型对多语言、方言甚至手语的实时识别能力,使其成为协作与无障碍沟通的工具某教育机构已将其集成至在线课程平台,自动为听障学生生成实时字幕与手语动画。

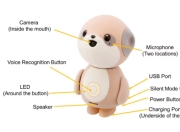

在可穿戴设备领域,FastVLM的低延迟特性正推动辅助技术迈向新阶段。苹果与国内盲人协会合作开发的“智能导盲眼镜”原型机,通过摄像头捕捉环境信息,并利用FastVLM在本地生成语音描述,帮助视障用户“听见”周围障碍物、交通信号甚至人脸表情。测试用户李明反馈:“以前需要依赖云端处理的设备总有时延,现在反应速度几乎与真人无异。”

版权声明

本文仅代表作者观点,不代表百度立场。

本文系作者授权百度百家发表,未经许可,不得转载。